-

- 고영중 교수 자연어처리연구실, SIGIR 2022 국제 학술대회 논문 2편 게재 승인

- 자연어처리연구실 허태훈석사과정, 박충원 석사과정(이상 인공지능학과)의 논문 2편이 인공지능 및 정보검색 분야의 top-tier 국제 학술대회(BK21 CS IF=4)인 SIGIR (The 45thInternational ACM SIGIR Conference on Research and Development in Information Retrieval) 2022에 최종 논문 게재가 승인되어 7월에 발표될 예정입니다. 1. Choongwon Park, Youngjoong Ko, “QSG Transformer: Transformer with Query-Attentive Semantic Graph for Query-Focused Summarization”,Proceedings of the 45thInternational ACM SIGIR Conference on Research and Development in Information Retrieval(SIGIR 2022), July 2022. 본 연구에서는 문서에서 질의에 알맞는 요약문을 생성하는 ‘질의 기반 문서 요약’ 의 성능을 높이기 위한 새로운 기법을 제안합니다. 제안 기법은 질의와 문서의 단어들을 여러 자연어처리 기술을 이용해 연결하여 하나의 그래프로 구성하고, 이를 요약문을 생성하는 것에 사용합니다. 구성된 그래프를 질의 기반 문서 요약에 효율적으로 활용하기 위해 새로운 그래프 인공신경망을 제안하고, 이를 트랜스포머 모델에 붙여 사용합니다. 두 개의 데이터셋을 이용한 실험 결과, 제안 기법이 이전 연구들의 성능을 모두 앞서는 결과를 보였습니다. 2. Taehun Huh and Youngjoong Ko, "Lightweight Meta-Learning for Low-Resource Abstractive Summarization", Proceedings of the 45th International ACM SIGIR Conference on Research and Development in Information Retrieval (SIGIR 2022), July 2022 본 연구에서는 레이블 된 학습 데이터가 적은 상태인 ‘저 자원 생성 요약’의 성능을 높이기 위한 새로운 기법을 제안합니다. 제안 모델에서는 적은 데이터를 활용하여 해당 도메인에 빠르게 적응시키기 위해 메타러닝을 사용합니다. 또한, 학습 동안 기존 언어 모델에 추가되는 경량화 모듈만 학습 가능하게 하여 적은 데이터에 과적합 되는 문제를 해결합니다. 총 11개의 요약 데이터셋으로 실험한 결과, 기존 연구 보다 더 높은 Rouge 스코어 성능을 얻었습니다.

-

- 작성일 2022-06-14

- 조회수 1523

-

- 성균관대, KT 및 GC와 힘 합쳐 대한민국 AI바이오헬스 산업 선도

- ▶ 성균관대 KT-GC, 26일 AI원팀 신규 참여를 위한 MOU체결 ▶ AI바이오헬스 영역에서 AI역량 공유하고, 사업화 및 연구 협력 예정 ▶ AI인재 및 초거대 AI개발 등 바이오뿐 아니라 원팀 AI경쟁력 강화 협력 성균관대학교(총장 신동렬)가 대한민국 대표 산∙학∙연 협의체인 ‘AI 원팀(AI One Team)’에 GC(녹십자홀딩스)와 함께 합류했다. 의료·헬스케어 전문기업 GC와 AI 융합연구 인프라의 강점을 가진 성균관대가 참여함으로써 바이오 헬스 영역에서도 AI를 활용한 사업화 및 공동 연구가 본격화 될 것으로 보인다. 성균관대는 26일 KT 송파빌딩에서 KT, GC와 대한민국 인공지능(AI) 1등 국가를 위한 업무협약을 체결했다. 행사에는 AI 원팀을 대표해 KT AI/DX융합사업부문장 송재호 부사장이 참석했으며, GC CR혁신부문장 장평주 부사장, 성균관대 자연과학캠퍼스 박선규 부총장 등 주요 관계자들이 참석했다. 성균관대는 AI 원팀 합류로 ▲현장 중심의 차별화된 연구 협력 ▲AI 융합연구를 위한 인프라 활용 ▲기업의 요구사항에 맞는 인력양성에 협력하기로 했다. AI 원팀의 산학연의 유기적 협력관계를 바탕으로 산업의 문제를 발굴하고, 이를 해결하기 위한 AI 기술과 솔루션을 개발한다는 계획이다. 뿐만 아니라 다자간 공동연구를 통해 초거대 AI 모델 개발과 같은 핵심 기술 개발에도 적극 참여할 예정이다. 또한 성균관대 인공지능대학원, 인공지능융합원, 삼성융합의과학원 등 AI 인재양성과 융합연구를 위해 성균관대의 역량과 인프라를 총동원해 바이오 헬스와 물류, 금융 등 AI 원팀의 다양한 산업 분야에서 협력하기로 했다. GC는 AI 원팀 참여기관들과 함께 ▲의료·헬스케어 AI 기술 및 서비스 개발 ▲AI 헬스케어 연구 시너지를 위한 상호 협력 ▲AI 역량 확보를 위한 인재육성에 나선다. 특히 GC는 AI 원팀에서 컴퓨터 비전으로 질병을 진단하고, 예측 및 예방하는 AI 연구를 진행하기로 했다. 또한, 병원과 의사 추천 모델과 같이 개인 맞춤형 AI 헬스케어 서비스를 개발하고, AI 기반 신약 개발도 적극 추진할 계획이다. 또한 AI 원팀에 참여하고 있는 대학 및 기업들과 바이오·헬스 분야의 사업 협력을 강화하고 기술력을 보유한 스타트업과도 협업할 예정이다. 나아가 GC 임직원들의 AI 역량을 키우고 AI 원팀의 AI 인재확보 프로그램에도 함께 참여한다는 계획이다. 특히 KT가 AI 원팀 기관들과 공동으로 개발한 기업 실무 AI 자격인증인 ‘AIFB(AI Fundamentals for Business)’를 성균관대 맞춤형 학사제도 ‘도전학기’ 및 졸업 요건에 도입했으며, 각 산업 영역 별 특성에 맞는 실무형 AI 교육과정을 개설할 계획이다. 한편 AI 원팀은 ‘인공지능(AI) 1등 국가 대한민국’을 목표로 ‘20년 2월에 출범해 KT, 현대중공업그룹, 한국과학기술원(KAIST), 한양대학교, 한국전자통신연구원(ETRI), LG전자, 한국투자증권, 동원그룹, 우리은행, ㈜한진 등이 참여하고 있으며, 이번 GC와 성균관대의 합류로 총 12개 기관이 AI 원팀에 참여하게 됐다. GC CR혁신부문장 장평주 부사장은 “이번 협력은 국내 디지털 헬스케어 분야의 선도적인 융합모델을 구축하는 좋은 케이스가 될 것“이라고 말했다. 성균관대 자연과학캠퍼스 박선규 부총장은 “AI 기술은 인류사회의 패러다임을 전환할 핵심기술이다”라며, “성균관대는 대학이 보유한 우수 교수진을 활용하여 AI 인재양성과 기술개발에 힘을 쏟을 것이다”라고 말했다. 이어 “AI One Team과 공동 R&D 빅 프로젝트 추진을 통해 시너지를 창출하고 국가 AI 경쟁력을 강화하는 것에 교육연구기관으로서의 사명을 다할 것”이라고 밝혔다. KT AI/DX융합사업부문장 송재호 부사장은 ”뛰어난 AI 연구역량을 보유한 성균관대학교와 GC가 AI 원팀에 참여했다”며, “향후 AI 원팀은 바이오 헬스 등의 분야로 AI 혁신을 지속 확산해 나갈 것”이라고 말했다

-

- 작성일 2022-05-27

- 조회수 1375

-

- 이광한 인공지능학과 석박통합과정 (우사이먼 교수 연구실), Kaggle에서 금메달 수상

- DASH (Data-driven AI Security HCI) 연구실 소속 석박통합과정 이광한 학생이 세계최고 ML Competition인 Kaggle에서 열린 ‘BirdCLEF 2022- Identify bird calls in soundscapes’ 대회에서 808팀중 9등을 차지하여 금메달을 획득했습니다. 해당 대회는 배경잡음이 섞인 오디오 데이터에서 새소리를 식별하는 대회로 1) 학습데이터와 추론데이터 사이의 분포가 다른 점 2) 데이터에 소수의 클래스가 존재한다는 점 3) 학습과 추론 사이에 데이터 차원이 다른 점 등의 여러 문제를 해결해야 했습니다. Noise에 대한 오버피팅을 피하고 이미지로 처리할 시 누리는 다양한 이점을 위해 오디오 데이터를 mel-spectogram으로 변환하였고, 모델 일반화 성능을 높이기 위해 다양한 노이즈와 배경소음을 주입하였습니다. 모델은 SED (Sound Event Detection) head를 사용한 모델과 classification 모델을 앙상블하여 최종적인 결과를 냈습니다.

-

- 작성일 2022-05-26

- 조회수 2118

-

- 우사이먼 교수 연구실 (한시호 석사졸업 학생) KDD 2022 논문 게재 승인

- DASH (Data-driven AI Security HCI) 연구실 소속 한시호(1저자)와 우사이먼성일(교신저자) 교수의 논문 “Learning Sparse Latent Graph Representations for Anomaly Detection in Multivariate Time Series”가 데이터 마이닝 분야 최우수 국제 학회인 KDD 2022(BK21 CS IF=4)의 Applied Data Science Track에 게재 승인되었습니다. 저자들은 사이버물리시스템의 잡음이 있는 고차원 센서 데이터 내 이상징후 탐지를 위해 희소 오토인코더와 그래프 신경망을 결합하여 동시 최적화 하는 FuSAGNet(Fused Sparse Autoencoder and Graph Net) 모델을 제안했습니다. 희소 오토인코더 모듈은 원본 센서 측정값의 희소 잠재 변수를 학습하고, 이는 순환 센서 임베딩을 통해 학습된 특징 간 관계와 함께 센서값 예측을 위한 그래프 신경망의 입력으로 사용됩니다. 하나의 데이터 샘플에 대한 예측값이 정상값 대비 크게 벗어날 경우 이상징후로 취급합니다. 학습된 희소 잠재 변수와 순환 센서 임베딩 벡터는 t-SNE 시각화를 통해 모델의 설명력을 위해서도 사용됩니다. “Learning Sparse Latent Graph Representations for Anomaly Detection in Multivariate Time Series”, a full paper by Siho Han (first author) and Professor Simon S. Woo (corresponding author) of DASH (Data-driven AI Security HCI) Lab has been accepted for publication at the Applied Data Science Track of KDD 2022 (BK21 CS IF=4), a premier international conference for data mining. The authors proposed FuSAGNet (Fused Sparse Autoencoder and Graph Net), a model combining Sparse Autoencoder and Graph Neural Network to detect anomalies in high-dimensional, noisy sensor data from cyber-physical systems through joint optimization of reconstruction and forecasting. The Sparse Autoencoder module learns a sparse latent representation of the original sensor readings which, along with feature interdependencies learned through recurrent sensor embedding, are used as input to a Graph Neural Network module for sensor behavior forecasting. A sample of sensor readings is considered anomalous if its predicted values largely deviate from values under normal operating conditions. Learned sparse latent representations and recurrent sensor embedding vectors are also used for providing model interpretability by visualization through t-SNE plots. FuSAGNet 구성도

-

- 작성일 2022-05-20

- 조회수 1315

-

- 한태희 교수 SKKU Teaching Award 수상

- 반도체시스템공학과/인공지능학과 한태희 교수가 SKKU Teaching Award 수상자로 선정되었다. SKKU Teaching Award 제도는 교육의 질적 향상을 선도한 교/강사를 선정해 포상하는 영예로운 상으로, 교육 역량이 뛰어난 교/강사의 자긍심과 명예를 드높이고, 양질의 교육 제공을 위한 동기부여를 진직, 확산 시키는데 목적을 두고 있다. SKKU Teaching Award은 지난 5월 13일 금요일 600주년 기념과 제1회의실에서 개최되었다. *SKKU Teaching Award 수상자 한옥영(학부대학), 윤민향(학부대학), 백영선(유학.동양학과), 황호덕(국어국문학과), 오종우(러시아어문학과), 이아름(철학과), 구정우(사회학과), 서미혜(미디어커뮤니케이션학과), 이승덕(경제학과), 심수옥(경영대학), 배상훈(교육학과), 김보성(한문교육과), 이진민(디자인학과), 송창식(화학과), 한태희(반도체시스템공학과), 이대호(인터랙션사이언스학과), 구자춘(기계공학부), 이의경(약학과), 권대혁(융합생명공학과), 이준열(글로벌바이오메디컬공학과)

-

- 작성일 2022-05-16

- 조회수 947

-

- 김유성 교수 연구실 (김유성 교수,김경수,하정수 석사과정 학생) IJCAI 2022 논문 게재 승인

- CSI (Computer Systems and Intelligence) Lab. 연구실 김경수, 하정수 석사과정과 김유성 교수 논문 "Self-Predictive Dynamics for Generalization of Vision-based Reinforcement Learning " 가 인공지능 분야 최우수 학회 (BK IF=4) International Joint Conferences on Artificial Intelligence (IJCAI) 2022 에 게재 승인되었습니다. 카메라로 관측된 이미지 데이터만으로 로봇, 자동차, 장비 등을 제어하는 비전 기반 강화학습 연구 에서는 실제 제어와 무관한 시각적 방해요소가 학습을 방해하는 어려움이 있습니다. 더불어 학습 후 실제 환경에서 테스트시에는 시각적 방해요소가 (예: 그림자, 날씨 변화 등) 더욱 다양할 수 있는 만큼 학습의 일반화 및 강건한 제어가 요구됩니다. 본 논문에서는 관측된 이미지에 다중 데이터 증강을 적용하고 새롭게 제안한 자기지도 학습 기법을 통해 제어에 밀접한 특징(feature) 만을 효율적으로 추출하는 시각적 방해요소에 강건한 모델을 설계하였습니다. 본 연구는 다양한 비전 기반 로봇 제어 환경과 자율 주행 시뮬레이터 (CARLA) 에서 시각적 방해요소가 증가되어도 선행 연구 대비 학습 효율성이 크게 향상되었으며, 학습 후 새로운 시각적 방해요소 등장에도 가장 강건하게 제어할 수 있음을 보였습니다.

-

- 작성일 2022-04-21

- 조회수 1660

-

- 허재필 교수 연구실, CVPR 2022 논문 2편 게재 승인

- 비주얼컴퓨팅연구실(지도교수: 허재필)의 논문 2편이 컴퓨터 비전 및 인공지능 분야의 Top-tier 학술대회인 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) 2022에 게재 승인되었습니다. 논문 #1: “Local Attention Pyramid for Scene Image Generation” (인공지능학과 박사과정 심상헌, 인공지능학과 박사과정 현상익, 인공지능학과 박사과정 배대현) 논문 #2: “Task Discrepancy Maximization for Fine-grained Few-Shot Classification” (인공지능학과 석사과정 이수빈, 인공지능학과 석사과정 문원준) “Local Attention Pyramid for Scene Image Generation” 에서는 장면 영상 생성(scene image generation)에서 물체 별 품질 불균형 문제(class-wise visual quality imbalance issue)가 발생한다는 것을 확인하였으며, 이를 완화하기 위해서 새로운 네트워크 모듈을 제안하였습니다. 제안하는 모듈은 장면 영상의 특징인 여러 물체가 전체 영상에 산재해 있다는 점에 착안하여, 생성모델이 여러 로컬 영역들(local regions)에 높은 주의 점수(attention score)를 계산하도록 설계하였습니다. 본 연구에서는 제안된 기법을 이미지 생성분야의 여러 선행 연구들에 적용하였으며, 일관되게 이미지 생성 품질이 향상됨을 확인하였습니다. “Task Discrepancy Maximization for Fine-grained Few-Shot Classification” 에서는 Fine-grained few-shot classification의 성능향상을 위한 모듈(Task Discrepancy Maximization, TDM)을 제시하였습니다. Few-shot classification은 기존에 학습하지 않았던 카테고리를 적은 수의 라벨링 데이터로 학습하는 분야입니다. 제안하는 모듈은 라벨링 된 데이터(Support-set)을 이용하여 각 카테고리별 차별적인 특징을 예측하고 강조하는 서브모듈(Support Attention Module, SAM)과 분류해야 하는 데이터(Query-set)을 이용하여 분류 대상과 관련 있는 특징을 강조하는 서브모듈(Query Attention Module, QAM)로 구성되어 있습니다. 제안된 모듈은 기존 방법들의 성능을 모두 향상시켰으며 Fine-grained few-shot classification 분야에서 가장 높은 성능을 달성하였습니다. [논문 #1 정보] Local Attention Pyramid for Scene Image Generation Sang-Heon Shim, Sangeek Hyun, DaeHyun Bae, and Jae-Pil Heo IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2022 Abstract: In this paper, we first investigate the class-wise visual quality imbalance problem of scene images generated by GANs. The tendency is empirically found that the class-wise visual qualities are highly correlated with the dominance of object classes in the training data in terms of their scales and appearance frequencies. Specifically, the synthesized qualities of small and less frequent object classes tend to be low. To address this, we propose a novel attention module, Local Attention Pyramid (LAP) module tailored for scene image synthesis, that encourages GANs to generate diverse object classes in a high quality by explicit spread of high attention scores to local regions, since objects in scene images are scattered over the entire images. Moreover, our LAP assigns attention scores in a multiple scale to reflect the scale diversity of various objects. The experimental evaluations on three different datasets show consistent improvements in Frechet Inception Distance (FID) and Frechet Segmentation Distance (FSD) over the state-of-the-art baselines. Furthermore, we apply our LAP module to various GANs methods to demonstrate a wide applicability of our LAP module. [논문 #2 정보] Task Discrepancy Maximization for Fine-grained Few-Shot Classification SuBeen Lee, WonJun Moon, and Jae-Pil Heo IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2022 [Oral presentation] Abstract: Recognizing discriminative details such as eyes and beaks is important for distinguishing fine-grained classes since they have similar overall appearances. In this regard, we introduce Task Discrepancy Maximization (TDM), a simple module for fine-grained few-shot classification. Our objective is to localize the class-wise discriminative regions by highlighting channels encoding distinct information of the class. Specifically, TDM learns task-specific channel weights based on two novel components: Support Attention Module (SAM) and Query Attention Module (QAM). SAM produces a support weight to represent channel-wise discriminative power for each class. Still, since the SAM is basically only based on the labeled support sets, it can be vulnerable to bias toward such support set. Therefore, we propose QAM which complements SAM by yielding a query weight that grants more weight to object-relevant channels for a given query image. By combining these two weights, a class-wise task-specific channel weight is defined. The weights are then applied to produce task-adaptive feature maps more focusing on the discriminative details. Our experiments validate the effectiveness of TDM and its complementary benefits with prior methods in fine-grained few-shot classification.

-

- 작성일 2022-03-31

- 조회수 2104

-

- 이지형 교수 연구실, CVPR 2022 논문 게재 승인

- 정보 및 지능 시스템 연구실(지도교수: 이지형)의 김누리(전자전기컴퓨터공학과 석박과정)의 “Propagation Regularizer for Semi-supervised Learning with Extremely Scarce Labeled Samples” 논문이 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) 2022에 게재 승인되었습니다. CVPR은 컴퓨터 비전 및 인공지능 분야의 Top-tier 학술대회이며, 2022년에는 미국 뉴올리언스에서 개최됩니다. 본 연구에서는 기존 준지도 학습(Semi-Supervised Learning, SSL)에서 레이블 데이터가 클래스 당 1~2개밖에 없는 상황에서 성능 향상을 위한 Regularization 방법과 CVPR NewOrleansLogo_WebsiteCorner모델 선택 방법을 제안합니다. 레이블 데이터가 매우 부족한 상황에서 SSL은 학습 과정에서 확증 편향(Confirmation bias) 문제가 심각하게 나타난다는 것을 확인했으며, 이를 완화하기 위해서 언레이블 데이터에 대한 pseudo-label의 엔트로피를 최대화하는 Regularization을 제안합니다. 또한 레이블 데이터가 매우 부족한 상황에서 SSL은 확증 편향으로 인하여 학습 과정이 매우 불안정함을 확인했으며, 이러한 상황에서 검증 데이터를 추가로 활용하지 않고 최적의 모델을 선택하기 위한 방법을 제안합니다. 제안된 Regularization 방법과 모델 선택 방법을 통해 CIFAR-10, CIFAR-100, SVHN 데이터에서 기존 방식 대비 8.9%에서 120.2%까지 향상된 성능을 달성하였습니다.

-

- 작성일 2022-03-10

- 조회수 1792

-

- 우사이먼성일 교수 연구실(DASH Lab)의 The Web Conference (WWW) 논문 2편 게재 승인

- Data-driven AI Security HCI(DASH Lab) 연구실 학생 1) 이상엽 (소프트웨어학과 석박과정 연구원), 안재주 (소프트웨어학과 석사과정 연구원)과 우사이먼성일 (교신저자)의 논문 “BZNet: Unsupervised Multi-scale Branch Zooming Network for Detecting Low-quality Deepfake Videos”과 2)소프트웨어학과 Shahroz Tariq (소프트웨어학과 박사과정 연구원), 전소원 학생(소프트웨어학과 석사과정 연구원), 우사이먼성일 교수(교신저자)의 “Am I a Real or Fake Celebrity? Evaluating Face Recognition and Verification APIs under Deepfake Impersonation Attack” 논문 2편이 웹/데이터 마이닝 분야 최우수 학회The Web Conference (WWW) 2022 ( https://www2022.thewebconf.org/) (BK IF=4)에 게재 승인되었고, 2022년 4월 프랑스 리옹/온라인으로 발표될 예정입니다. 1)논문1. “BZNet: Unsupervised Multi-scale Branch Zooming Network for Detecting Low-quality Deepfake Videos” 특정 대상을 모방하는 딥페이크 생성 기법의 발전으로 사회는 가짜 뉴스나 잘못된 정보 전파에 취약해졌지만 최근 활발한 연구를 통해 다양한 딥페이크 탐지 기법들이 연구되었습니다. 하지만, 최근 SNS나 웹에 실제 배포되는 딥페이크 동영상은 저장공간 확보를 위해 저화질 비디오로 압축되어 기존의 탐지 기법의 성능을 저하시킵니다. 이를 해결하기 위해 본 연구에서는 Unsupervised Super-resolution (SR) 기법과 multi-scale 이미지를 동시에 학습하는 모델인 Branch Zooming Network (BZNet)을 개발하여 저화질 딥페이크 동영상을 탐지하였습니다. 탐지 모델 학습 시 학습용 고화질 딥페이크 동영상을 사용하지 않고 저화질 동영상만을 사용했다는 점에서 새로운 유형의 딥페이크의 저화질 배포 동영상만 존재하는 현실이 잘 반영되었다고 평가됩니다. 세부적으로, 본 논문에서는 저화질 딥페이크 탐지모델 BZNet을 두 단계로 나누어 학습을 진행합니다. 첫번째 단계는 주어진 저화질 딥페이크 이미지의 퀄리티를 N개의 고화질 이미지 크기로 높여주는 Unsupervised SR N개 모듈들을 학습합니다. 두번째 단계에서는 학습된 모듈을 활용하여 생성한 각기 다른 N개 이미지들을 활용하여 CNN기반 모델을 학습합니다. 이때, 여러 화질 이미지를 화질별로 나누어 학습하는 것이 아닌, 한 모델에 동시 입력으로 사용하여 학습하는 방법을 제안하였습니다. 저화질 딥페이크 영상을 다양한 화질의 이미지로 변환 후 multi-scale 학습법을 통해 저화질 딥페이크의 화질 변화 특징 추출 능력을 극대화할 수 있었고, 최신 탐지 모델과 비교하여 그 중 가장 높은 성능을 낼 수 있었습니다. 뿐만 아니라, 기존의 CNN기반 모델에 본 연구에서 개발한 Branch Zooming Module을 적용하여 저화질 이미지에 대한 분류 성능을 높임으로써, 이후 저화질 이미지 분류 문제 해결에 대한 가능성을 보였습니다. 2)논문2. “Am I a Real or Fake Celebrity? Evaluating Face Recognition and Verification APIs under Deepfake Impersonation Attack” 본 연구에서는 딥페이크를 활용한 사칭 공격 (Deepfake Impersonation Attack)에 대한 얼굴 인식 API 와 오픈소스 툴들의 취약성을 시험합니다. 마이크로소프트, 아마존, 네이버 등에서 제공하는 영리 목적의 얼굴 인식 웹 서비스는 높은 정확도를 자랑하며, 다양한 멀티미디어 어플리케이션에 활용되고 있으나, 이러한 얼굴 인식 웹 서비스는 정교한 ‘딥페이크’ 기술의 발전으로 자연스레 누구나 빠르게 사칭 공격을 수행 가능한 환경에 노출되었습니다. 이에 본 연구에서는, 얼굴 인식 웹 서비스와 오픈소스 툴 중에서도 ‘유명인 얼굴 인식’ 서비스를 대상으로 딥페이크 사칭 공격을 수행한 결과, Targeted Attack (TA)의 경우 78.0%의 높은 공격 성공률을 보였습니다. 또한 본 연구에서는 적대적 훈련 기법을 사용하여 Targeted Attack 공격 성공률을 1.26%까지 감소시키는 딥페이크 사칭 공격 완화 전략을 제안하였습니다.

-

- 작성일 2022-02-03

- 조회수 1590

-

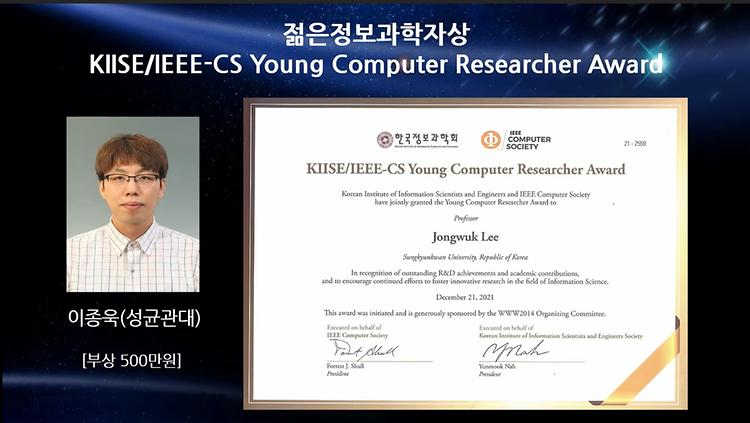

- 소프트웨어학과 이종욱 교수 한국정보과학회 "젊은 과학자상" 수상

- 한국정보과학회는 강원도 평창에서 열린 올해 한국소프트웨어 종합학술대회에서 “6회 젊은 과학자상” 수상자로 성균관대 소프트웨어학과 이종욱 교수를 선정하였다. “젊은 과학자상”은 정보과학 발전에 공로가 인정되고 연구 개발 실적이 뛰어나며 발전 잠재력이 우수한 만40세 이하의 연구자에게 IEEE-CS와 공동으로 수여하는 상이다. 이종욱 교수는 데이터마이닝, 데이터베이스 및 인공지능 분야에서 우수한 학술 업적을 높이 평가받아 수상자로 선정되었다. 한국정보과학회는 1973년 설립되었으며, 현재 일반회원 39,000여명, 특별회원 156기관, 단체회원 278개 기관이 등록되었으며, 컴퓨터 분야에서 국내 최대 규모의 학회이다.

-

- 작성일 2021-12-30

- 조회수 1172